Das Versprechen der künstlichen Intelligenz in der industriellen Welt war schon immer monumental - eine Vision von Fabriken, die ihre eigenen Bedürfnisse vorhersehen, von Fließbändern, die ihre eigenen Prozesse perfektionieren, und von Abläufen, die ein beispielloses Maß an Effizienz erreichen. Für viele ist dies jedoch eine ferne Vision geblieben, die durch die immense Herausforderung behindert wurde, die Lücke zwischen industriellen Daten und KI-gestützten Erkenntnissen zu schließen. Wir freuen uns, heute eine bahnbrechende Zusammenarbeit ankündigen zu können, die diese Barriere durchbricht und die Zukunft der industriellen Autonomie in die Gegenwart holt: Litmus Edge wird jetzt von der neuen NVIDIA DGX Spark unterstützt und ist bereit, Ihre Abläufe zu verändern.

Der Weg zur Implementierung von industrieller KI war zu lange von Komplexität geprägt. Die industrielle Landschaft ist ein Geflecht aus Altsystemen, proprietären Protokollen und isolierten Datenquellen. Diese Daten, das Lebenselixier der KI, sind oft gefangen, fragmentiert und schwer nutzbar. Das Ergebnis ist eine Kluft zwischen dem Wunsch nach KI-gestützter Optimierung und der Realität komplexer, zeitaufwändiger und teurer Implementierungszyklen. Die Hersteller waren gezwungen, sich zwischen langsamen, schrittweisen Fortschritten oder riskanten, groß angelegten Überholungen zu entscheiden. Das ist das Problem, das wir lösen. Die Frage war schon immer: Wie können wir die Time-to-Value beschleunigen und jedem Industrieunternehmen den Zugang zu leistungsstarker KI ermöglichen?

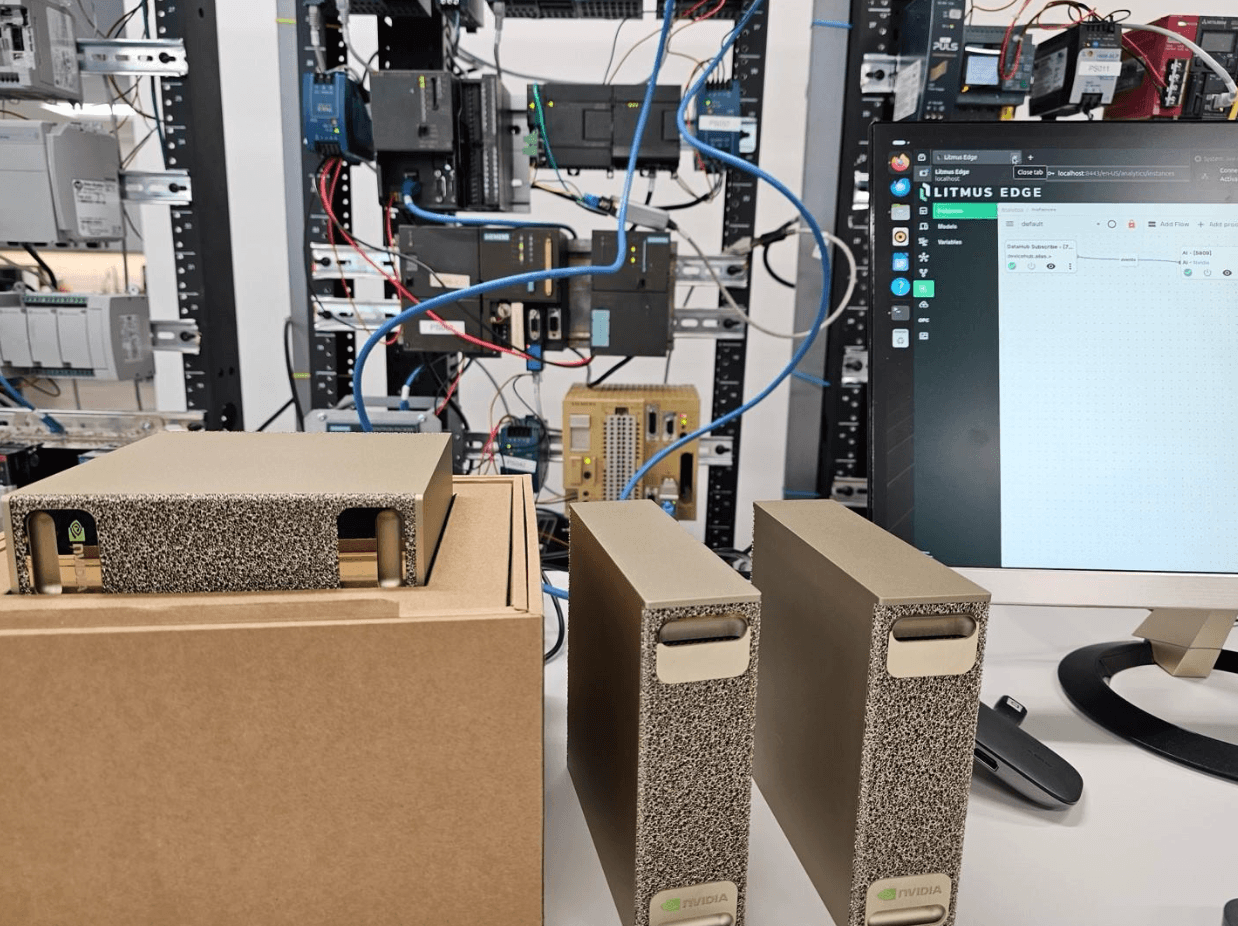

Die Antwort liegt in einem disziplinierten Ansatz für industrielle Daten, den wir Industrial DataOps nennen. Es handelt sich dabei um die grundlegende Schicht, die Daten aus allen Industrieanlagen sammelt, standardisiert und kontextualisiert und sie für die unmittelbare Nutzung in Analyse- und KI-Anwendungen vorbereitet. In diesem Bereich hat sich Litmus Edge schon immer hervorgetan. Jetzt, mit der Leistung von NVIDIA DGX Spark, machen wir einen Quantensprung nach vorne. Wir treten in eine neue Ära der industriellen KI ein, in der die Leistung der Cloud direkt in der Fertigung eingesetzt wird. NVIDIA DGX Spark ist eine kompakte, leistungsstarke und effiziente Plattform, die für lokale KI-Inferenz entwickelt wurde. Sie ist ein entscheidender Faktor für industrielle Umgebungen, da sie den Einsatz anspruchsvoller KI-Modelle direkt an der Schnittstelle ermöglicht - dort, wo die Daten generiert werden und wo Echtzeitentscheidungen am wichtigsten sind.

Litmus Edge ist seit Jahren führend bei der Ausführung von Small Language Models (SLMs) in einer Vielzahl von Anwendungsfällen in der Fertigung und ermöglicht vorausschauende Wartung, Qualitätskontrolle und Prozessoptimierung. Mit der Rechenleistung von NVIDIA DGX Spark können wir jetzt viel leistungsfähigere Large Language Models (LLMs) lokal einsetzen. Stellen Sie sich eine KI vor, die nicht nur einen Maschinenausfall vorhersagen, sondern auch sofort die Ursache analysieren und dem Bediener vor Ort Korrekturmaßnahmen in natürlicher Sprache anbieten kann. Das ist die Leistung von LLMs am Edge. Das ist die Leistung von Litmus Edge auf DGX Spark.

Der Einstieg in Litmus Edge auf NVIDIA DGX Spark ist ein unkomplizierter, Docker-basierter Prozess. Im Folgenden finden Sie einen Überblick darüber, wie Sie die Leistung von On-Premise-KI in Ihre industrielle Umgebung bringen können:

- 1.

Bereiten Sie Ihr DGX Spark vor: Stellen Sie sicher, dass auf Ihrem System das NVIDIA DGX OS (Ubuntu) läuft und die Docker Engine vorinstalliert ist. Sie benötigen einen ausgehenden Netzwerkzugang und den offenen Port 8443 für den Zugriff auf das Dashboard.

- 2.

Bereitstellen von Litmus Edge: Ziehen Sie das Docker-Image von Litmus Edge und führen Sie es aus. In wenigen Minuten können Sie über einen Webbrowser mit der IP-Adresse Ihres DGX Spark auf das Litmus Edge-Dashboard zugreifen und eine Verbindung zu Ihren Industrieanlagen herstellen.

- 3.

Erweitern Sie mit lokalen LLMs: Um leistungsstarke LLMs lokal auszuführen, setzen wir das beliebte und leichtgewichtige Framework Ollama ein. Ollama wird in einem separaten Docker-Container auf demselben DGX Spark bereitgestellt und ermöglicht Ihnen das einfache Abrufen und Verwalten einer Vielzahl von KI-Modellen wie Llama, Mistral oder Gemma.

- 4.

Integrieren und Analysieren: Das ist der Punkt, an dem die Magie passiert. In Litmus Edge Analytics fügen Sie einfach eine neue Verbindung zu Ihrer Ollama-Instanz hinzu. Sobald die Verbindung hergestellt ist, stehen Ihre lokalen LLMs für die nahtlose Integration von KI-Modellen zur Verfügung. Sie können dann leistungsstarke Datenflüsse erstellen und einen KI-Prozessorknoten hinzufügen, um Echtzeit-Inferenz-Workflows zu erstellen, die die volle Leistung von DGX Spark nutzen.

Sind Sie bereit, die Auswirkungen zu sehen? Hier sind drei hochwertige Projekte, mit denen Sie noch heute beginnen können:

Operator Co-Pilot für die Ursachenanalyse: Streamen Sie SPS-Fehlercodes in Litmus Edge. Verwenden Sie ein LLM, das lokal auf dem DGX Spark läuft, um kryptische Fehlercodes sofort in einfach verständliche Fehlerbehebungsschritte und empfohlene Maßnahmen zu übersetzen, die direkt an die HMI oder das mobile Gerät des Bedieners gesendet werden.

Visuelle Defekterkennung in Echtzeit: Schließen Sie eine Kamera an die Produktionslinie an und streamen Sie das Videomaterial in Litmus Edge. Setzen Sie ein vorab trainiertes Computer-Vision-Modell ein, um Qualitätsprobleme - wie Kratzer, Fehlausrichtungen oder Verpackungsfehler - zu erkennen, sobald sie auftreten, und lösen Sie Echtzeitwarnungen aus oder leiten Sie Produkte automatisch um.

Erweiterte Anomalie-Erkennung: Gehen Sie über einfache Schwellenwertwarnungen hinaus. Mit Litmus Edge können Sie Daten von mehreren Sensoren (Vibration, Temperatur, Druck) sammeln und zusammenführen. Geben Sie diese umfangreichen, kontextualisierten Daten in ein Anomalieerkennungsmodell auf dem DGX Spark ein, um Geräteausfälle mit höherer Genauigkeit und weniger Fehlalarmen vorherzusagen.

F: Was ist der Hauptvorteil der Ausführung von Litmus Edge auf NVIDIA DGX Spark?

A: Der Hauptvorteil ist die Möglichkeit, leistungsstarke industrielle KI-Modelle in Echtzeit, einschließlich Large Language Models (LLMs), direkt in der Fertigung auszuführen. Dies reduziert die Latenzzeit, verbessert die Datensicherheit und beschleunigt die Time-to-Value für KI-gesteuerte Anwendungsfälle.

Litmus Edge sammelt und bereitet Echtzeitdaten aus industriellen Anlagen auf.

Ollama (LLM-Laufzeit) führt lokale KI-Modelle auf der GPU von DGX Spark aus, um eine schnelle lokale Inferenz zu ermöglichen.

Der KI-Workflow von Litmus Edge orchestriert diese Modelle, um innerhalb von Millisekunden Erkenntnisse und Entscheidungen zu liefern.

F: Muss ich ein Datenwissenschaftler sein, um diese Lösung nutzen zu können?

A: Nein. Litmus Edge ist benutzerfreundlich gestaltet, und die Integration mit NVIDIA DGX Spark und Ollama vereinfacht die Bereitstellung von vortrainierten KI-Modellen. Betriebsteams können Modelle problemlos einsetzen und verwalten, um sofortige Erkenntnisse zu gewinnen.

F: Wie verarbeitet diese Lösung Daten von älteren Industrieanlagen?

A: Litmus Edge eignet sich hervorragend für die Verbindung mit einer Vielzahl von Industrieanlagen, sowohl modernen als auch älteren. Es kann Daten von Hunderten von Protokollen und Systemen sammeln, normalisieren und kontextualisieren, so dass sie für die Analyse durch die KI-Modelle, die auf DGX Spark laufen, bereit sind.

Die Ära der langsamen, komplexen und kostenintensiven industriellen KI ist vorbei. Mit Litmus Edge powered by NVIDIA DGX Spark ist der Weg zu einem intelligenteren, effizienteren und widerstandsfähigeren Fertigungsbetrieb klarer und schneller als je zuvor. Dies ist mehr als nur ein neues Produkt; es ist ein neues Paradigma für die industrielle Welt. Es ist an der Zeit, den Hype hinter sich zu lassen und das wahre Potenzial der industriellen KI zu erkennen. Sind Sie bereit, loszulegen, haben aber noch keine Hardware? Wir haben die Lösung für Sie.

Wenden Sie sich an unser Kundenerfolgsteam, um sich über unser DGX Spark-Leihprogramm zu erkundigen, und lassen Sie uns Ihnen helfen, Ihre Reise in die industrielle KI zu beginnen.